新华社发

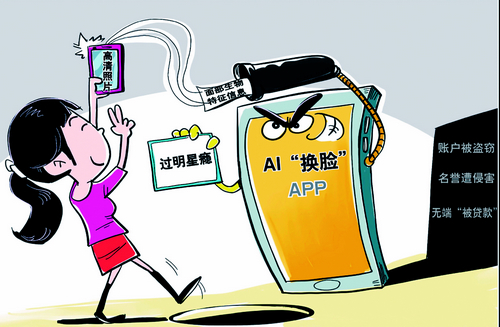

通过AI换脸和拟声技术,10分钟骗430万元;AI虚拟人在聊天中筛选出受害者,人工接力实施诈骗……近期,多起宣称利用AI技术实施诈骗的案件引发关注。

记者近日与公安部门核实确认,“AI诈骗全国爆发”的消息不实,目前此类诈骗发案占比很低。公安机关将加大力度会同有关部门开展技术反制和宣传防范。专家表示,随着AI技术加速迭代,由于使用边界不清晰,涉诈风险正在积聚,需要高度警惕。 据新华社

“换脸”式诈骗引发焦虑:你会被亲友的脸骗到吗?

近日,内蒙古包头警方通报一起利用AI实施诈骗的案件,福州市某公司法人代表郭先生10分钟内被骗430万元。据通报,骗子通过AI换脸和拟声技术,佯装熟人实施诈骗。

那么,“AI诈骗潮”是否真的到来了?

记者调查了解到,AI在技术上确实能做到换脸、拟音,但被用来进行“广撒网”式诈骗需要具备很多条件。一位被列入公安部专家库的民警告诉记者,这类诈骗如果得手必须做到:收集到被换脸对象的个人身份信息、大量人脸图片、语音素材,通过AI生成以假乱真的音视频;窃取被换脸对象的微信号;充分掌握诈骗对象个人身份信息,熟悉其与被换脸对象的社会关系,综合作案成本很高。

他认为:“相关报道对一些案件的典型细节描述不够准确。AI涉诈案件仍属零星发案状态。”他说,成熟的类型化诈骗犯罪往往具有在全国多地集中爆发的特点,但当前没有成规模的AI诈骗类案件发生。

公安机关研判,近期网上“AI换脸换声诈骗在全国爆发”传言不实,全国此类案件发生不到10起,但该动向值得高度关注。网上一键换脸功能的App、小程序有技术滥用风险,需要加强技术防范反制等工作。

AI进入快速迭代期 涉诈犯罪风险正在积聚

“当前AI技术发展来到螺旋式上升的拐点,未来几年技术迭代将会按月计算。”香港科技大学(广州)协理副校长、人工智能学域主任熊辉说。工信部信息显示,伴随AI技术快速发展,合成技术门槛持续降低,逐渐向低算力、小样本学习方向演进,利用手机终端即可完成,对算力和数据的要求下降明显。同时,随着AI大模型的技术加持,正逐步由面部合成向全身、3D合成发展,效果更加逼真。

国家开发投资集团特级专家、厦门美亚柏科AI研发中心总经理赵建强表示,AI技术正加速向网络诈骗、虚假信息、色情等领域渗透。如在一些网络平台上假冒明星、公众人物生成视频图像,吸引网民。此外,AI技术也可能被用来规模化地实施违法犯罪,如批量、自动维护网络账号,发送虚假信息,模拟人工在线聊天等。

“老话说‘眼见为实’,但今后眼睛看到的也不一定是真实的。”北京市天元律师事务所合伙人杨虎城表示,未来涉及AI合成技术的诈骗、敲诈勒索等违法犯罪和肖像、名誉等民事侵权问题可能逐步显现。

“从现有案例看,这些技术已被不法分子利用。虽然AI诈骗案件未成气候,但这一趋势值得关注,必须提早防范。”一位反诈民警说。

工信部相关负责人表示,随着AI技术的不断发展,利用人工智能模型批量设计诈骗脚本等成为可能,客观上降低了电信网络诈骗的实施难度,AI类新型犯罪爆发可能性进一步提升。

【链接】

尽快完善相关法规制度

为AI技术发展立规划线

业内人士建议,要加强AI反制技术研究,“以AI制AI”。一些科技公司正加强对图像、声音伪造技术的反制研究,在公安、金融的视频认证场景已有应用。有一线民警建议,要加强AI安全技术应用研发,将AI技术应用于犯罪识别、预警、对抗中,实现以“白”AI对抗“黑”AI。

其次,加强源头治理和行业引导,及时更新、完善相关法律、标准、规则,为AI技术发展保驾护航。

“数据是AI犯罪的源头,保护好公民的个人隐私数据安全,就能在最大程度上降低AI违法犯罪的能力。”熊辉说。

中国互联网协会监管支撑部主任郝智超建议,AI技术发展还要有相关法律法规来划红线、踩刹车。需进一步加强对个人隐私数据泄露问题的关注,明确信息监管红线,对AI技术的研发、传播、使用做到有规可循,并根据技术发展实际情况,及时完善对技术服务商行为的规范引导。